# 数据变换

# 常用方法与考量

数据变换是处理回归模型中非正态性或非恒定方差问题的一种常见方法。

- 右偏数据(数据集中存在一些非常大的值,拖动了平均值向右)可以通过取平方根、对数或倒数来使其分布更接近对称。

- 左偏数据(数据集中存在一些非常小的值,拖动了平均值向左)可以通过取平方、立方或更高的幂次来使其分布更接近对称。

# 潜在问题与替代方案

尽管数据变换看似有用,但它也带来一些挑战:

- 变换后的数据失去了原有的直观解释。例如,对数收入的回归系数不再是每增加一个单位的自变量带来的收入变化。

- 变换改变了模型的原始假设,例如,误差项的分布可能不再是正态的。

- 变换后的模型不一定能保证正态性或方差的稳定性,有时反而会引入新的问题。

- 通过逆变换得到的置信区间可能会有偏差。

- 数据变换可能使模型无法直接回答我们最初感兴趣的问题。

- 它改变了误差项的分布和方差。

鉴于上述问题,在某些情况下,可以考虑以下替代方法:

- 广义线性模型 (GLM):能够直接处理非正态分布的因变量。

- 重采样方法:如自助法 (Bootstrap),通过对数据进行多次重采样来估计参数和置信区间。

- 非参数方法:不依赖于特定分布假设,例如树模型等。

# 模型选择

# 常用指标与经验法则

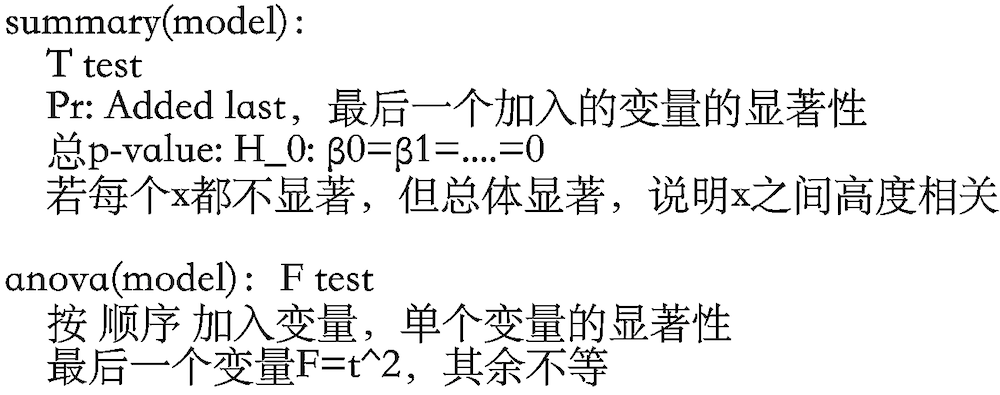

在多元线性回归中,选择最佳预测变量组合是一个重要环节。R 语言中的 ANOVA 表是评估模型表现的常用工具。

选择模型时,可以遵循以下经验法则:

- 逐一分析变量:首先,通过图形(如散点图、直方图)和摘要统计量(如均值、中位数)单独地理解每个变量的分布和性质。

- 探索变量间关系:使用绘图和相关性分析来探索变量间的成对关系,这有助于识别多重共线性等潜在问题。

- 注意变量的重要性变化:一个变量在单独作为预测因子时可能非常重要,但在包含其他变量后,它的显著性可能会降低甚至消失。

- 回归系数的动态性:回归系数、标准误和显著性检验的结果会依赖于模型中包含的其他解释变量。

- 综合考量:显著性检验(p 值)并不能说明全部问题,(决定系数)可以从另一个角度衡量模型对数据的解释能力。在实际应用中,需要结合对数据收集过程、变量性质和相互关联的理解来做出综合判断。

# 多元线性回归检验

# 单个系数的检验

多元线性回归中,每个回归系数 都有其对应的统计检验。

- 系数的分布:在假设满足回归模型的前提下,回归系数 服从正态分布:

- 标准误:回归系数 的标准误可以被估计为:

- 假设检验:为了检验单个自变量是否对因变量有显著影响,我们通常设置原假设为 。

- t 统计量:对应的 t 统计量为:

其中, 是模型的自由度。

# 参数与预测的置信区间

-

单个系数置信区间:

我们可以利用 t 分布来构建单个回归系数 的置信区间:此外,残差平方和 可以用来估计误差方差 :

其中, 是残差均方。

-

响应均值 的置信区间:

在给定的预测变量向量 下,响应变量的均值 (即 )的估计值 遵循正态分布: -

单个响应 的预测区间:

预测区间用于预测在给定 下单个响应值 的可能范围。与置信区间不同,预测区间需要考虑额外的预测误差。其标准误的平方为:

因此,我们可以利用 t 分布来构建预测区间: